支持向量机:不均衡数据集的分割超平面¶

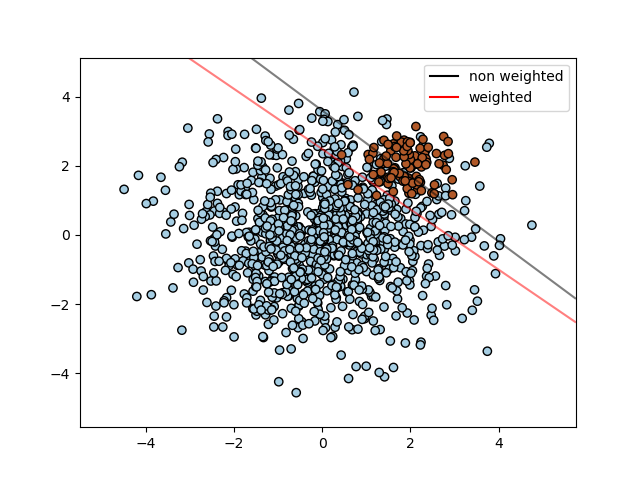

对于样本不均衡的数据,使用SVC查找最佳分割超平面。

我们首先找到普通SVC的分割平面,然后用虚衔绘制对不平衡的样本类进行自动校正的分割平面。

注意:通过将SVC(kernel =“ linear”)替换为SGDClassifier(loss =“ hinge”),这个案例中的代码也可以跑通。将SGDClassifier的损失函数设置为hinge将产生类似线性核的SVC的行为。

例如,尝试代替SVC:

clf = SGDClassifier(n_iter=100, alpha=0.01)

输出:

输入:

print(__doc__)

import numpy as np

import matplotlib.pyplot as plt

from sklearn import svm

from sklearn.datasets import make_blobs

# 创造两簇随机的点

n_samples_1 = 1000

n_samples_2 = 100

centers = [[0.0, 0.0], [2.0, 2.0]]

clusters_std = [1.5, 0.5]

X, y = make_blobs(n_samples=[n_samples_1, n_samples_2],

centers=centers,

cluster_std=clusters_std,

random_state=0, shuffle=False)

# 拟合模型并得到分割超平面

clf = svm.SVC(kernel='linear', C=1.0)

clf.fit(X, y)

# 拟合模型并得到处理了样本不平衡的分割超平面

wclf = svm.SVC(kernel='linear', class_weight={1: 10})

wclf.fit(X, y)

# 绘制样本

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.Paired, edgecolors='k')

# 为两个分类器绘制决策边界

ax = plt.gca()

xlim = ax.get_xlim()

ylim = ax.get_ylim()

# 创造网格来评估模型

xx = np.linspace(xlim[0], xlim[1], 30)

yy = np.linspace(ylim[0], ylim[1], 30)

YY, XX = np.meshgrid(yy, xx)

xy = np.vstack([XX.ravel(), YY.ravel()]).T

# 绘制分割的超平面

Z = clf.decision_function(xy).reshape(XX.shape)

# 绘制决策边界和边际

a = ax.contour(XX, YY, Z, colors='k', levels=[0], alpha=0.5, linestyles=['-'])

# 绘制做了样本平衡后的分割的超平面

Z = wclf.decision_function(xy).reshape(XX.shape)

# 绘制做了样本平衡后的决策边界和边际

b = ax.contour(XX, YY, Z, colors='r', levels=[0], alpha=0.5, linestyles=['-'])

plt.legend([a.collections[0], b.collections[0]], ["non weighted", "weighted"],

loc="upper right")

plt.show()

脚本的总运行时间:(0分钟0.144秒)